2024年5月27日,北京大学国家发展研究院、北大数字金融研究中心举办了春季学期的第十一次数字金融Workshop。加州大学伯克利分校的Joshua Blumenstock教授分享了题为“Manipulation-proof Machine Learning(防操纵机器学习)”的研究。本次Workshop由北大国发院助理教授、中心研究员胡佳胤主持,四十余位师生在线上参与会议并与主讲嘉宾进行了深入的交流和讨论。

Blumenstock教授首先介绍了算法决策在现代社会中的广泛应用,包括搜索结果、社交媒体、贷款审批、招聘、刑事审判等领域。他指出,算法在这些领域的决策往往会被用户刻意操纵和利用。例如,用户可以通过改变搜索关键词得到理想的搜索结果,操纵个人健康数据以获得更便宜的保险,在贷款审批中进行欺诈,改变SEC文件中的用词以操纵情感评分等。

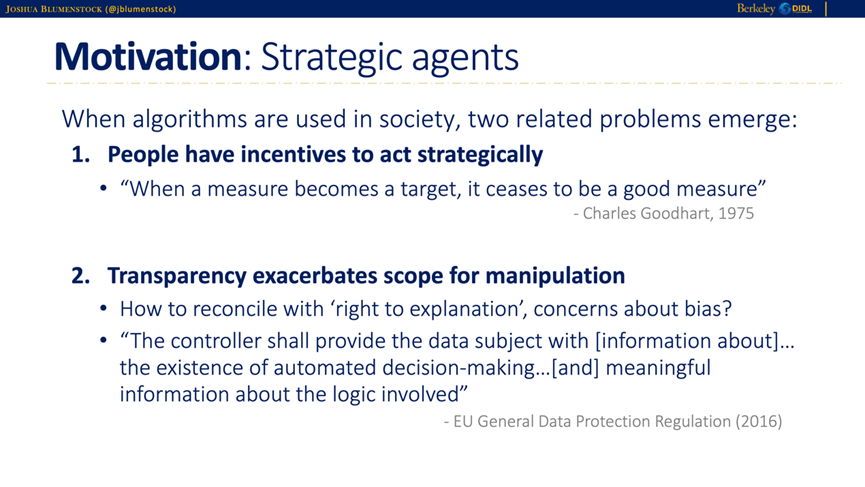

Blumenstock教授指出,当算法在社会中被广泛使用时,会出现两个相关问题。首先,人们有动机去采取策略性行为,正如Charles Goodhart在1975年所说,“当一个指标成为目标时,它就不再是一个好的指标(When a measure becomes a target, it ceases to be a good measure)”。其次,算法透明度会加剧操纵的程度。这会导致对透明度的追求和对偏见的担忧产生冲突。

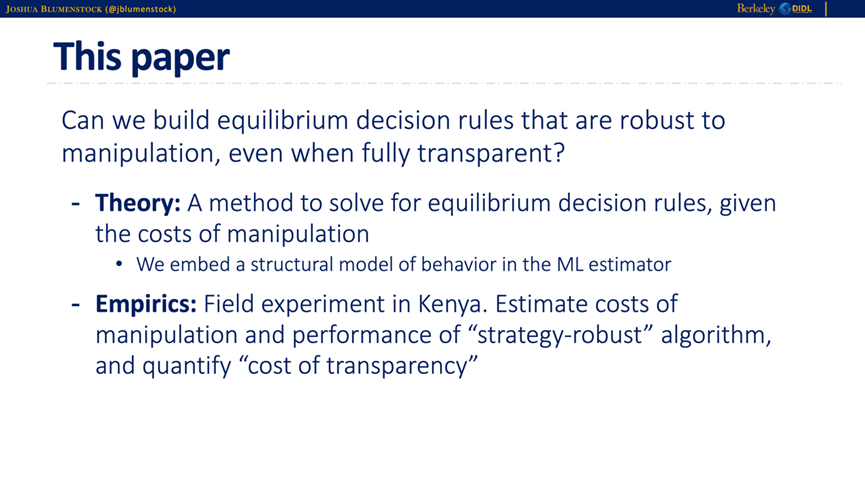

针对这些问题,Blumenstock教授及其合作者提出了一种能够抵御操纵的平衡决策规则,即使在完全透明的情况下也能保持稳健性。在理论方面,他们通过嵌入行为的结构模型到机器学习估计器中,解决了给定操纵成本的平衡决策规则问题。在实证方面,他们在肯尼亚进行了实地实验,估算了操纵的成本和“策略稳健”算法的性能,并量化了“透明度成本”。这项研究展示了如何在现实世界中应用这种方法来提高算法决策的可靠性和稳健性。

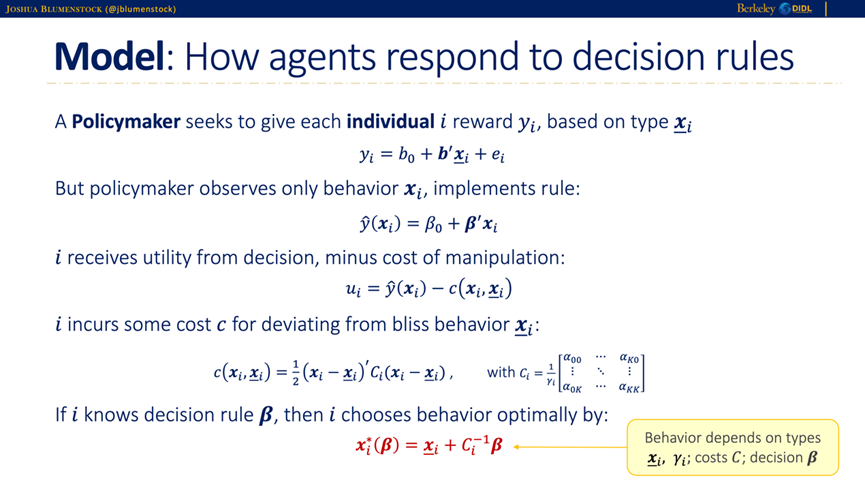

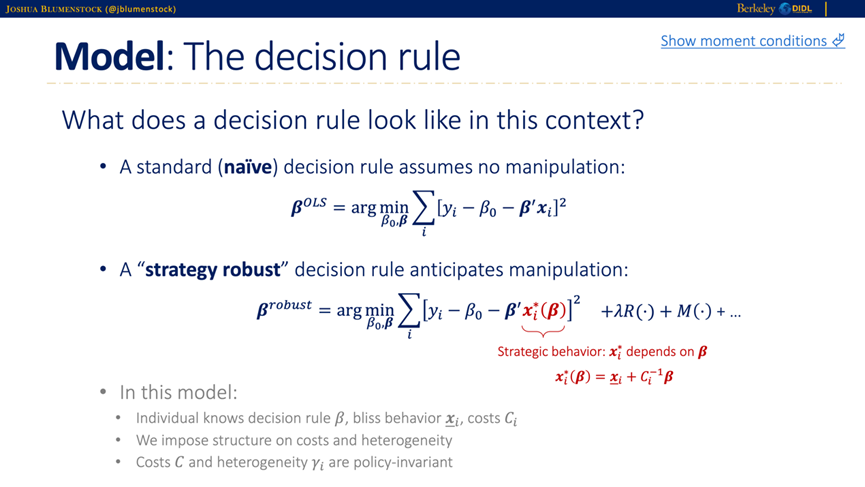

传统的普通最小二乘法(OLS)通过最大化样本内拟合来进行估计,而其他估计方法如LASSO和工具变量法则分别牺牲样本内拟合来获得样本外拟合和因果估计。Blumenstock教授的策略稳健估计方法通过牺牲样本内拟合(in-sample fit)来提高对抗操纵的拟合效果(counterfactual fit),具体来说,该方法假设个体会对决策规则做出最佳反应,从而在对抗操纵行为时保持预测的稳定性。具体模型设定如下。决策者希望根据每个个体的类型给予奖励,但只能观察到个体的行为。具体来说,决策者使用观察到的行为来实施规则,个体根据此规则获得效用,同时承担操纵行为的成本。个体的总效用由决策带来的效用减去操纵成本来表示,操纵成本是个体偏离其最佳行为的代价。如果个体知道决策规则,他们会选择最优的行为模式来最大化自己的效用。个体的行为取决于其类型、操纵成本和决策规则。

在这一模型设定下,策略稳健决策规则预见到操纵行为,并通过最小化包含策略性行为的误差来确定。

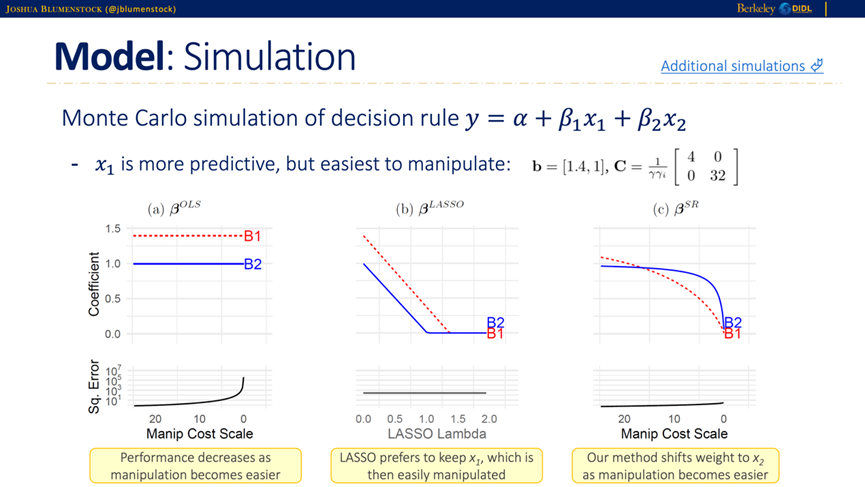

Blumenstock教授展示了通过蒙特卡罗模拟进行的决策规则评估。模拟结果显示,当操纵变得更加容易时,标准的普通最小二乘法(OLS)的性能显著下降,因为它未能考虑操纵行为。LASSO仍然倾向于保留容易被操纵的变量。而策略稳健方法则在操纵变得更容易时,逐渐将权重转移到不易被操纵的变量上,从而提高了决策规则在面对操纵时的稳定性和性能。

接下来,Blumenstock教授介绍了在肯尼亚进行的实地实验。在实地实验的环境中,有价值的资源是根据观察到的行为分配的。实验的主要目标是估算操纵成本、类型和异质性,并测试标准模型(na?ve model)和策略稳健模型(robust model),同时计算透明度的均衡成本。

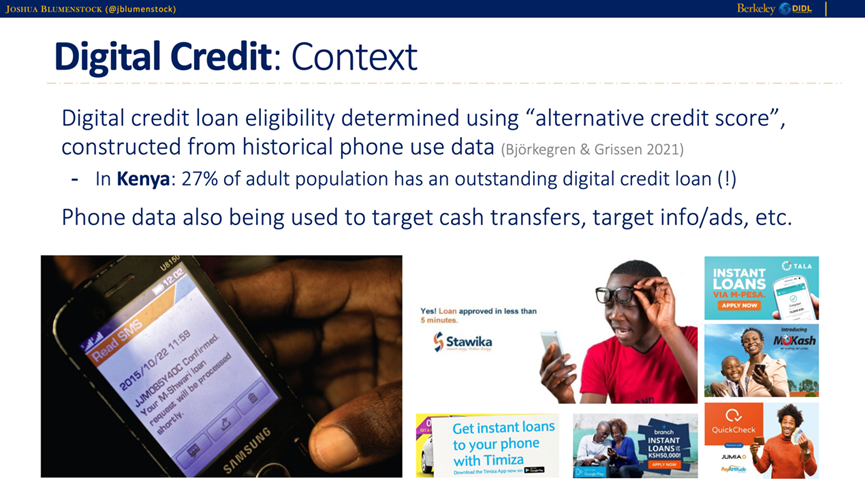

实验利用了肯尼亚的数字信贷场景,通过手机数据构建“替代信用评分”,这些评分基于用户的历史电话使用数据来决定贷款资格。Blumenstock教授提到,肯尼亚27%的成年人有未偿还的数字信贷贷款,这显示了手机数据在金融服务中的广泛应用和重要性。

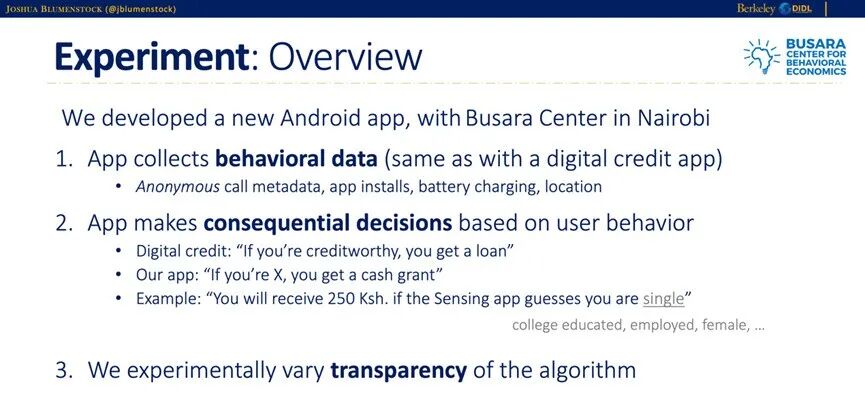

在实验中,研究团队开发了一款新的安卓应用,该应用收集用户的行为数据,例如通话元数据、应用安装情况、电池充电和位置信息。这些数据用于进行关键决策,例如确定用户是否有资格获得贷款或现金奖励。为了测试透明度对用户行为的影响,实验还设置了不同的算法透明度条件,观察用户在透明和不透明条件下的行为变化。

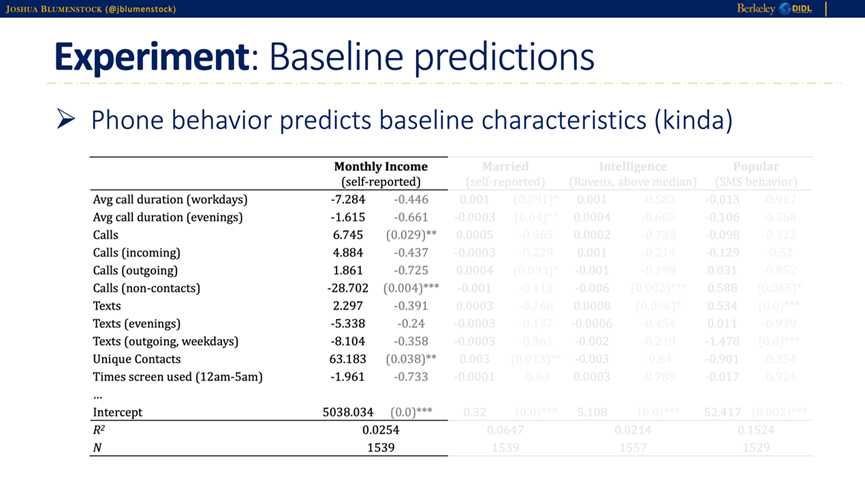

在基准预测阶段,研究团队使用手机行为数据预测用户的基准特征,例如月收入和婚姻状况。结果表明,手机行为在某种程度上可以预测这些基准特征,但预测效果有限。例如,工作日平均通话时长、晚间通话时长和非联系人通话次数等变量对月收入的预测有一定的统计显著性,但总体上解释能力较弱。

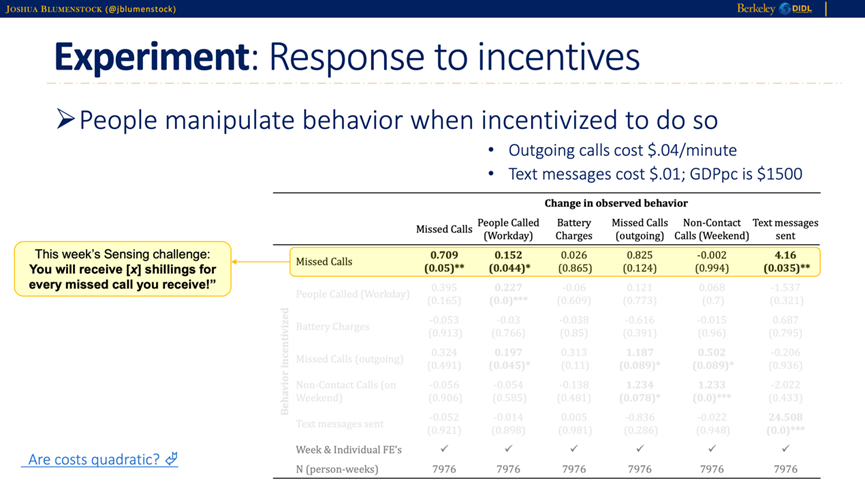

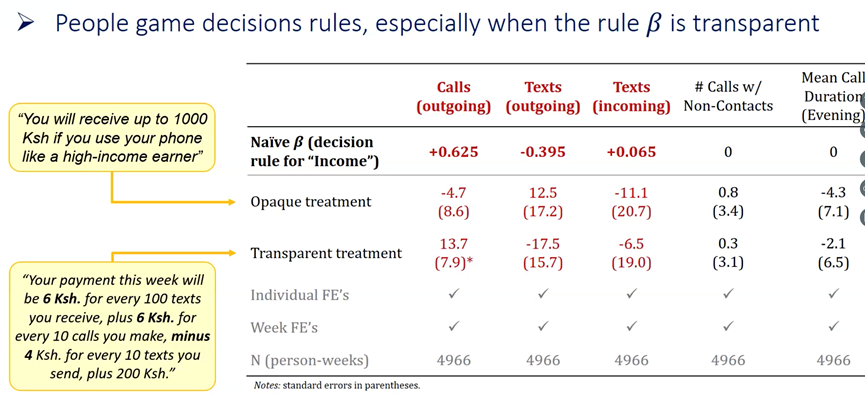

当用户被告知每接到一个未接电话可以获得奖励时,他们显著增加了未接电话的数量。这表明用户在有激励的情况下,会操纵自己的行为以获得更多的奖励。例如,每发送一条短信或拨打一个电话的成本较低,因此用户在激励条件下会调整自己的行为模式,以最大化自己的收益。

通过GMM估计的方法,作者发现了透明的决策规则会导致更多的操纵行为。

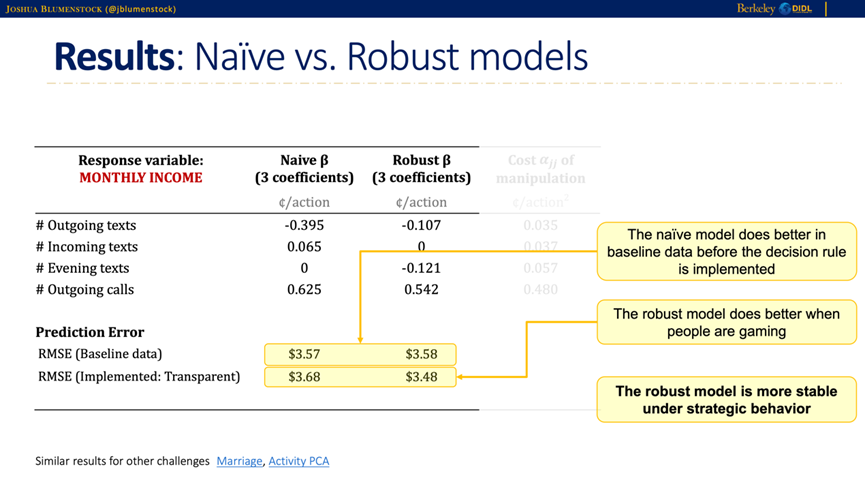

在对比标准模型和策略稳健模型的结果时,Blumenstock教授指出,策略稳健模型在面对操纵行为时表现更为稳定和准确。标准模型在基准数据下表现较好,但在实施后,由于用户的操纵行为,其性能显著下降。相比之下,策略稳健模型能够更好地应对这些操纵行为,通过选择更高操纵成本的特征,显著减少了操纵行为,并在透明条件下保持较高的预测准确性。

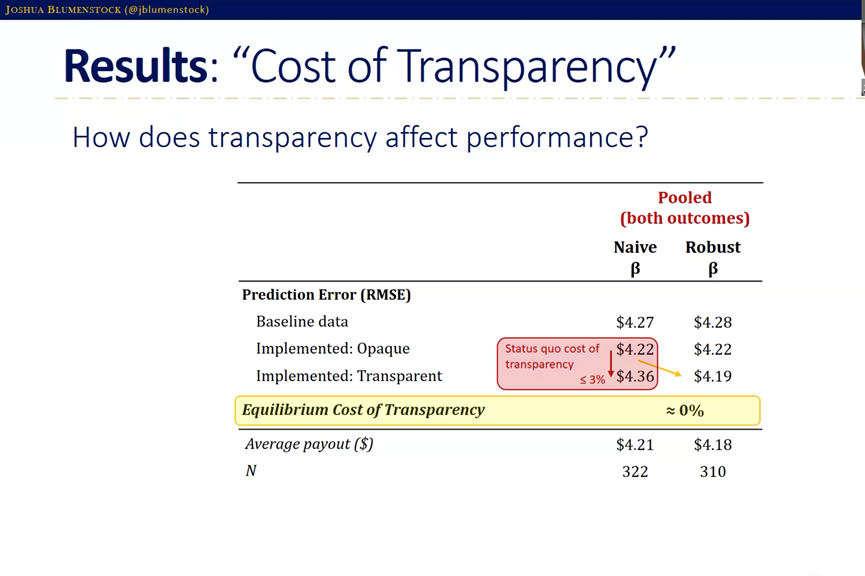

结果表明,透明度的均衡成本接近于零,这意味着透明算法在实际应用中的可行性较高。

Blumenstock教授的研究表明,策略稳健估计在应对操纵行为时具有显著优势,能够在透明条件下保持预测的稳健性。这项研究为在现实世界中如何应用透明且防操纵的机器学习决策规则提供了新的思路和方法,展示了防操纵机器学习在实际应用中的广泛前景。通过构建能够抵御操纵的决策规则,可以显著提高算法决策的稳定性和可靠性,从而为政策制定者和企业提供更有效的工具,帮助他们在复杂的环境中做出更明智的决策。

在讲座过程中,北京大学国家发展研究院经济学教授汪浩,中南财经政法大学文澜学院院长、二级教授、北京大学数字金融研究中心特约高级研究员龚强,北京大学国家发展研究院和南南合作与发展研究院经济学助理教授彭聪,北京大学习近平新时代中国特色社会主义思想研究院助理教授、研究员陈佳,北京大学国家发展研究院博士生胡诗云、李星宇等就文献相关问题如模型设定、实地实验等同Blumenstock教授进行了深入交流。

Joshua Blumenstock是加州大学伯克利分校信息学院和高盛公共政策学院的副教授。他是全球政策实验室和全球有效行动中心的联合主任。Blumenstock的研究位于机器学习和实证经济学的交叉点,重点关注如何利用新数据和技术更好地满足世界各地贫困和脆弱人群的需求。他拥有加州大学伯克利分校的信息科学博士学位和经济学硕士学位,并在卫斯理大学获得了计算机科学和物理学的学士学位。他曾获得多个奖项,包括NSF CAREER award, Intel Faculty Early Career Honor, U.C. Berkeley Chancellor's Award for Public Service。他的研究成果发表在Science, Nature, Proceedings of the National Academy of Sciences等综合性期刊上,以及American Economic Review等顶级经济学期刊和ICML、KDD、AAAI、WWW、CHI等顶级计算机科学会议上。